如何破解AI推理延迟难题:构建敏捷多云算力网络

发布日期:2025-09-16浏览: 508

正如在上一篇文章《AI创业公司如何突破算力瓶颈,实现高效发展?》中所述,高效调度算力只是AI公司突破瓶颈的第一步。若没有与之匹配的网络架构,再精巧的算力策略也难以落地,算法更无法转化为稳定交付的服务。

那么,这套支撑AI商品化的网络架构,究竟是怎样的?

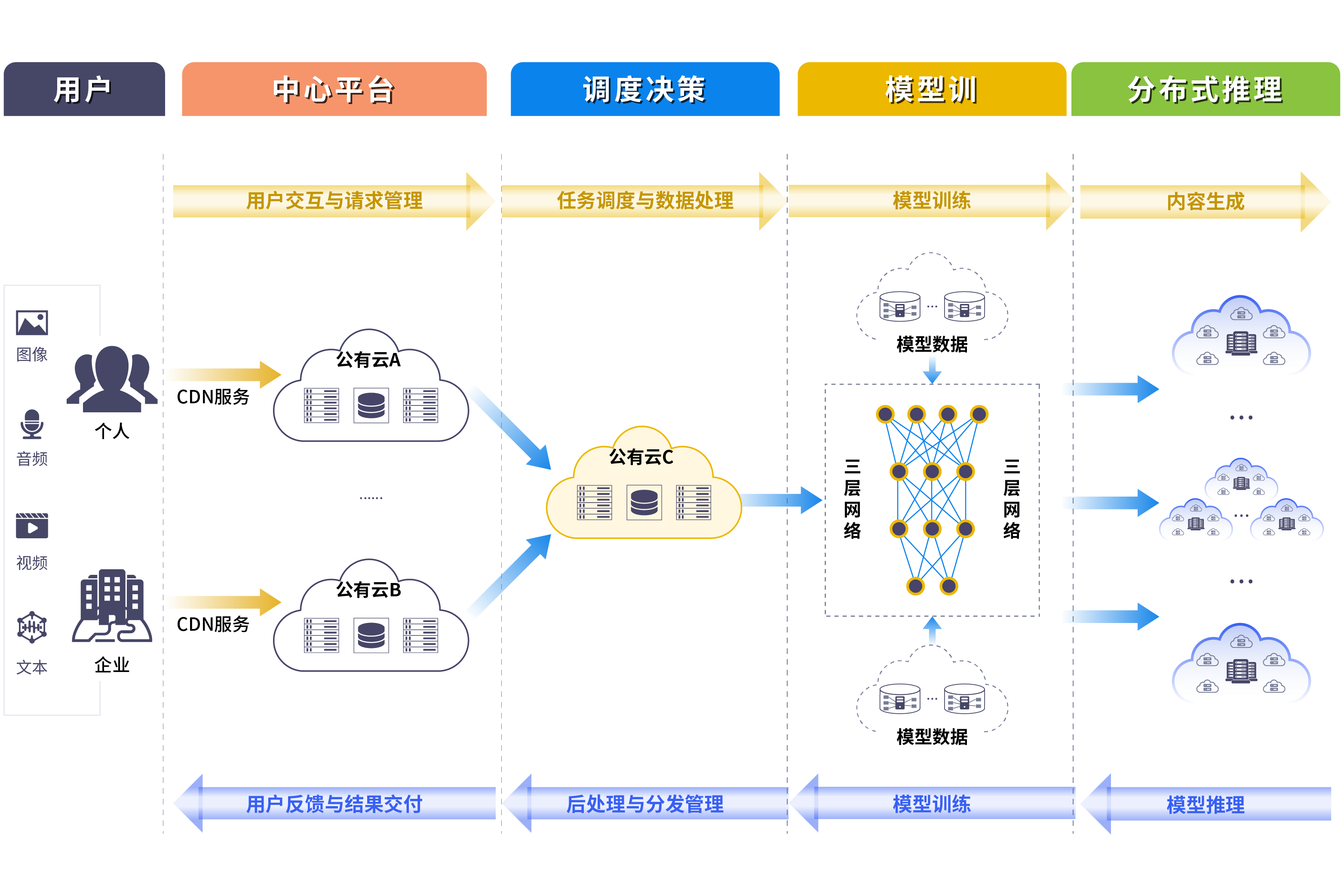

AI企业典型IT架构解析

随着文生图、文生视频等大模型应用的产品化落地,越来越多AI企业在“算法创新”之外,开始重视如何构建一个稳定、高效、可持续演进的IT础架构体系。以下是我们在客户交付中总结出的典型IT架构模式,一层一层揭示背后的资源与网络需求逻辑。

1、流量接入层 :流量“入口与缓冲带”

中心平台作为流量接入层部署在IT架构的前端,承担两个核心职责:

统一接入终端请求(来自 App / Web 端),对外作为平台的统一访问接口;

进行基础预处理,包括数据解包、请求鉴权、地域识别、异常过滤等操作。

它是 AI 服务的“流量入口”,更是后端系统的第一道防线,在业务高并发或全球分发场景下显得尤为关键。

2、调度决策层 :算网资源的“智能中枢”

调度平台位于中心平台与算力之间,是整个架构的“大脑”模块。它的作用不是计算,而是决策:

接收中心平台转发的推理请求;

结合实时的节点资源状态、成本、负载等因素,将请求智能分配到最合适的推理节点;

同时具备流量控制、降级策略、容灾调度等能力,是整个系统的“控制中枢”。

简单来说,它不跑模型、不存数据,只做一件事:把每一次推理请求送到最合适的地方。

3、推理服务层 :模型服务的“前线阵地”

推理平台是直接承接业务请求、完成模型推理计算的节点,具备以下特点:

分布广泛,通常部署在全国多个地域,贴近用户或边缘节点;

每次计算轻量,但请求量巨大、波动频繁,对响应延迟敏感;

支持通过调度平台统一调控,动态调整负载和服务策略。

它是业务实时体验的直接决定者,尤其适用于文生图、图生视频等多媒体生成型任务。

4、训练算力层:模型训练的强力引擎

相比推理平台,训练任务通常对资源有更高要求,训练平台需要具备:

大规模 GPU 资源,通常集中部署在少数几个高性能算力集群;

高带宽、低延迟的内网传输能力,以支撑海量训练数据读写;

更高的可靠性和调度容错能力,保障长时间、多节点的分布式训练任务不被中断。

它是支撑企业大模型开发、优化迭代的“底盘力量”。

这种架构分层,并不是为了复杂化系统,而是基于不同业务流程的资源诉求差异做出的专业划分。在这样的分层架构下,AI 企业可以实现更高的系统弹性、更好的资源利用率,以及更强的运维掌控力。

AI架构对网络的实战挑战

AI 企业一开始就在设计此类分层架构的同时,同步提出了网络部署的明确要求。

以一家专注于文生图的AI初创企业为例,在产品上线前夕突遇训练节点调度不稳定的问题,溯源发现是网络在多云资源池间连接延迟过高。正是这种架构“刚跑起来,网络就掉链子”的场景,让他们意识到:网络不再是配角,而是业务运行逻辑的一部分。

在这些真实客户场景中,我们观察到以下几类关键诉求:

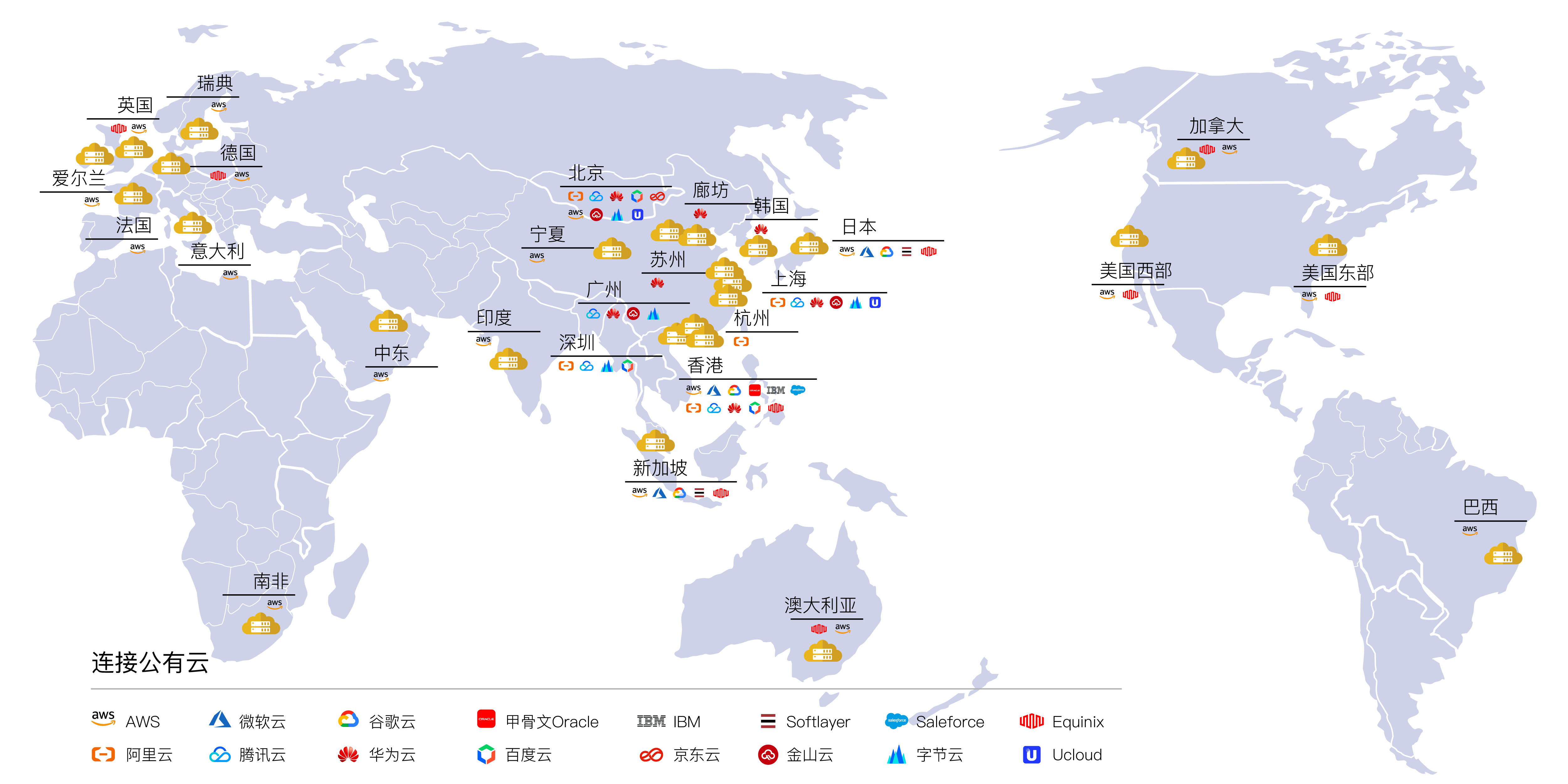

网随云动:跨域多云敏捷互联

AI 企业为了追求成本最优、资源充沛、性能达标,会根据训练和推理任务的不同,将资源部署在不同地域、不同云平台,甚至跨境。

这就要求网络具备以下能力:

■ 能够预连接多云资源,在架构初期就打通关键链路,避免后期修改带来不确定性;

■ 能根据训练/推理任务的不同,将网络流量引入不同的算力池

■ 能够支持未来资源池扩展,不受制于初期架构决定。

简单说:AI 架构选资源要自由,网络就必须跟得上变动、拖得起多云、容得下未来。

一张融合又隔离的网络

训练和推理虽然共享底层架构,但对带宽、延迟、合规等网络指标要求迥异:

■ 训练任务:带宽大、持续时间长、容忍延迟,重数据一致性与吞吐;

■ 推理服务:请求频繁、对响应延迟敏感,要求链路尽可能短、尽可能稳;

■ 海外数据调取:需合规、可控,路径可回溯、性能可保障。

因此,AI 企业真正需要的,不是“通一张网”,而是在一张网内能做出“逻辑隔离”与“差异管理”:

■ 训练与推理的数据走不同通道,互不干扰;

■ 关键推理流量可保障优先级,业务高峰期仍能正常调度;

■ 海外拉数据与中心调度路径独立,符合业务与安全双侧需求。

换句话说,一张能融合,又能隔离的网络,是支撑 AI 多业务协同运行的前提。

网络需“看得见、控得住”

大量AI企业在推理服务上线后,才首次遇到“链路调不动、性能不稳”的问题。可视化、QoS、策略化调度,不再是锦上添花,而是保体验、保成本的必选项。

尤其在推理服务爆发式增长后,企业面临以下挑战:

■ 难以监控整条链路(从端侧 → 中台 → 推理节点)的请求响应时延;

■ 当推理响应变慢时,无法快速定位是网络问题、调度延迟,还是推理节点负载过高;

■ 大量请求突发时,不同业务之间相互争抢链路资源,影响关键任务执行;

■ 海量流量下缺乏分类能力,无法实施分流、限速、优先级保障等 QoS 策略。

AI 企业对网络提出了更高要求:

■ 能实现端到端的全链路监控与告警,做到实时可视化;

■ 能识别业务流种类(推理、训练、调度)并进行策略分发;

■ 可设置推理业务的优先级保障,确保高峰期体验不下降。

换句话说,网络不仅要跑得快,还要知道自己在“跑什么”“跑得怎么样”“该怎么改跑”。

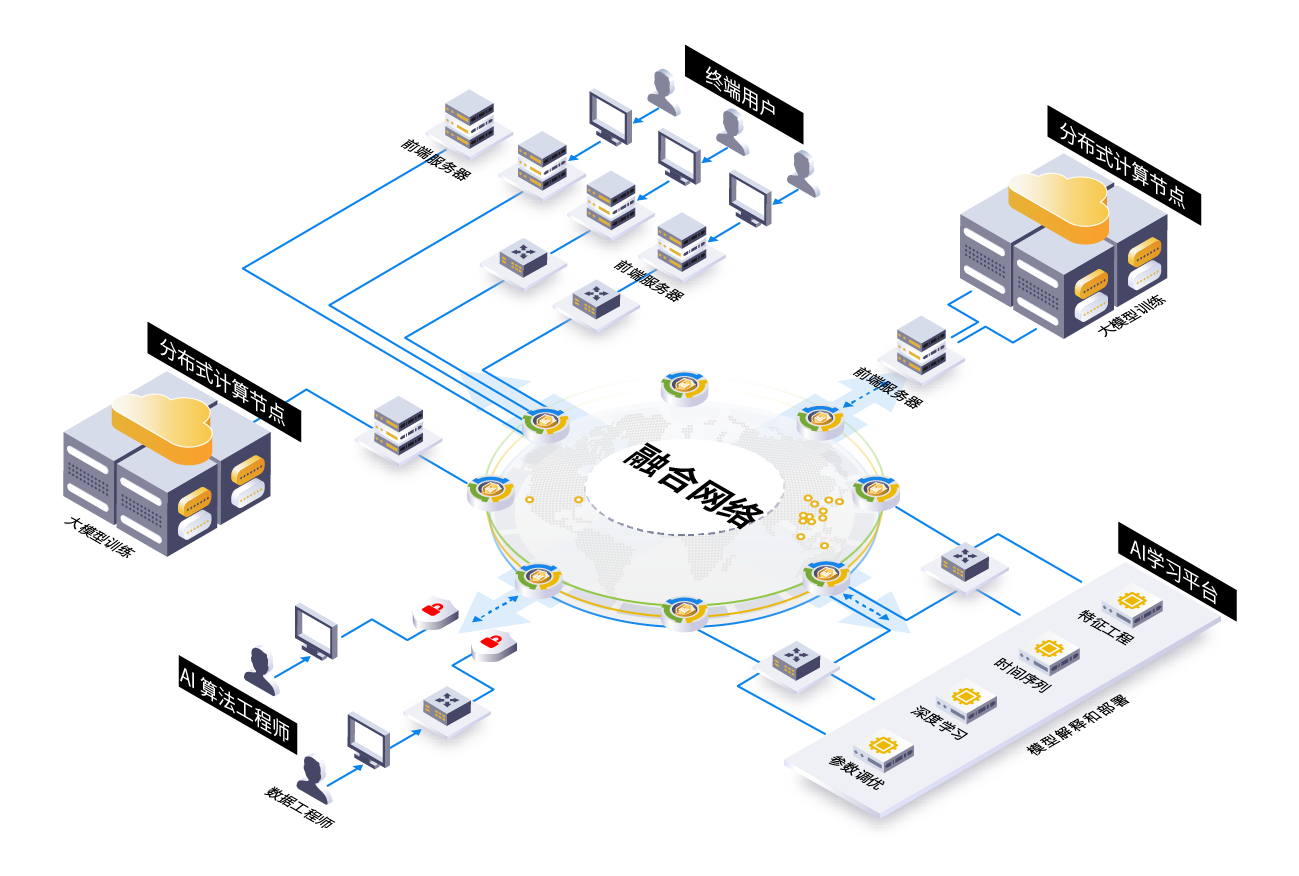

解锁AI潜力的一站式网络解决方案

犀思云与客户的合作过程,从一开始就深度参与了网络架构的设计与落地。我们围绕以下三大核心诉求,构建了一套既稳定、又灵活,还能进化的网络底座。

多云资源的无缝连接与调度

在客户规划不同平台上部署训练与推理节点时,犀思云提前为客户构建了多云资源互联的底层网络结构。这一设计具备三大优势:

#

预连接资源池

在各大主流平台之间建立稳定通道,不依赖公网,提前打通关键链路;

#

灵活资源切换

业务可按需迁移或横向扩展,不被单一平台绑定;

#

成本策略可控

网络成本与算力策略挂钩,支持在不同场景下做出最优调度。

多云策略成功的关键不是选得多,而是“连得快、换得顺、管得住”。

多业务融合承载网

客户的架构中,既有高带宽、长时延的训练流,也有轻量、敏感的推理服务,还有中心平台与海外中台的数据传输。

犀思云提供的网络能力,能够做到:

#

逻辑隔离

在同一张物理网络下,根据流量类型(训练、推理、调度等)进行策略隔离,避免资源抢占;

#

业务穿透能力

支持推理请求从端侧直达边缘推理平台、回传中心平台,再上传训练数据,路径可控;

#

跨境合规访问

海外中心与国内平台之间的数据交互,路径可管控、性能可预期,支持 AI 企业合规扩展。

无需建多张专网,一张融合网络,就能承载全业务流转。

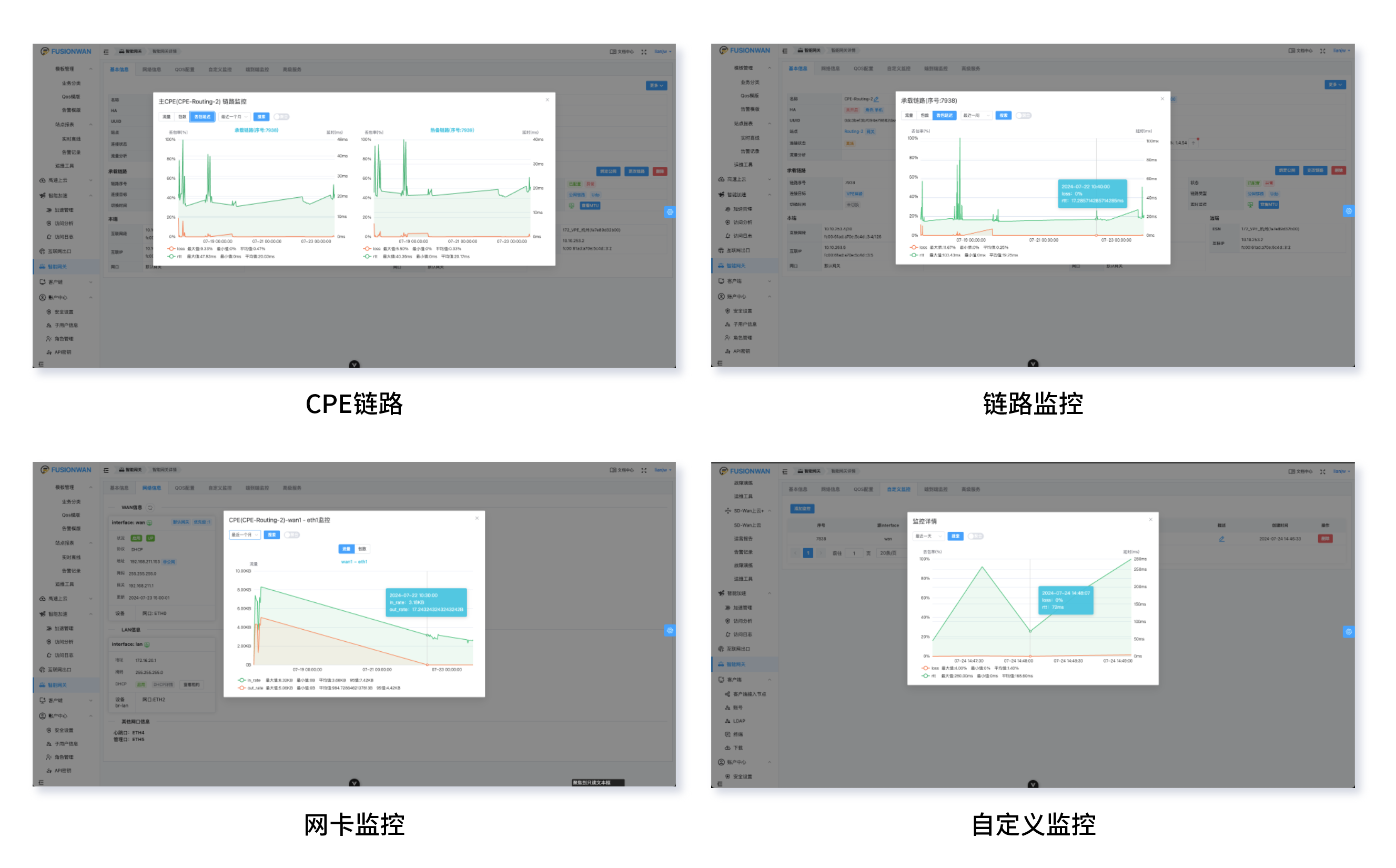

可视可控的 QoS 能力

对 AI 企业而言,影响业务的从来不是“是否通了”,而是“何时慢了”,“异常流量在哪”,“能不能马上调优”。

犀思云在网络侧,提供了覆盖“端到端”的可视化、流量分析与QoS管理能力,包括:

#

实时监控

支持监控推理请求从 中台 → 调度中心 → 推理平台的完整路径,识别异常流量、丢包、时延;

#

业务识别

识别并区分推理 vs 训练 vs 回源流量,设置不同带宽与优先级;

#

流量分析能力

支持对全链路业务流进行持续观察与分类,识别不同业务行为特征,逐步建立基于优先级的流控模型,为未来 QoS 精细化管理提供数据基础;

#

QoS分级管理

业务层可定义高优先级任务享有更高链路保障,确保关键服务稳定交付。

犀思云不是做“通路”的网络,而是做“懂业务”的网络。

在 AI 架构里,网络不是配角,而是先行者

在 AI 企业构建算力体系的每一步,网络都不再是“事后补齐”,而是同步规划、协同演进的基础。

犀思云通过可进化的网络底座,帮助客户实现:多云多地之间的快速接入与调度,训练、推理、调度业务的融合承载与隔离管理,从链路可视到业务优先的端到端精细化控制。

我们不是来“连通”的,而是来“懂业务、保体验、稳交付”的。

如果你正思考如何为下一阶段 AI 业务打好网络基础,不妨和犀思云聊聊。我们可提供一份基于你业务架构的网络诊断建议,帮你预判潜在瓶颈,提前打好底座。

迎接混合云下半场:Hybrid WAN赋能智能化的未来之路

在线教育扩张启航,数字化网络赋能

“连接器”国家助力出海:打破企业数据孤岛,构建高效全球网络

领先AI企业经验谈:探究AI分布式推理网络架构实践

终于找到了!符合新一代企业网的流量分析功能

犀思云荣获“深度用云”优秀实践奖,创新实践引领行业未来

企业研发生产的 “高速路”:专用融合网络

犀思云2024年终特辑:蓄势待发,智起新程

连锁药店网络优化策略:一站式融合方案提升竞争力

新四化驱动,如何构建智能汽车的“全场景”可进化互联网络?